최적화의 관점에서 Neural Net 보기

예측/분류모델로서의 신경망

• 예측모델의 Loss Function : 잔차(residual)

예측값과 실제값의 차이(잔차)가 얼마나 작은가

• 분류모델의 Loss Function : Cross-entropy

실제 레이블과 얼마나 일치하는가 작으면 작을수록 분류 good

위의 두 식은 대표적인 개념식이고 얼마든지 응용 가능 !!

ANN (Artificial Neural Network) 2

기존 인공신경망의 한계

• 기존 뉴럴넷의 한계 > 이미지, 텍스트, 복잡한 음성 신호 등을 처리하는

데에 있어 1개의 hidden layer로는 표현이 어려움

• 비선형 빅데이터의 복잡한 결합관계(ex. 이미지 데이터)를 표현하는 데

에 한계점 존재

• 더 날것(raw)의 데이터를 바로 분석하고자 하는 욕망

만약, layer를 (더 깊게) 늘린다면 ?

• 고차원 추상화 (High Level Abstraction) 작업 가능

• 앞부분 Layer > 변수간 결합 및 추상화 작업

• 뒷부분 Layer > 데이터의 분류(classification)

ANN에서 히든 레이어가 여러개 된게 딥러닝이다

이미지 데이터

Features of Image Data

• 각각의 픽셀 = 하나의 변수

• 학습할 파라미터의 수 多

• 모델의 complexity 증가, overfitting 가능성 증가

Spatially-Local Correalatio

-인접 픽셀 간 높은 상관관계

Invariant Feature

-부분적 특성은 고정도니 위치에 등장하지 않음

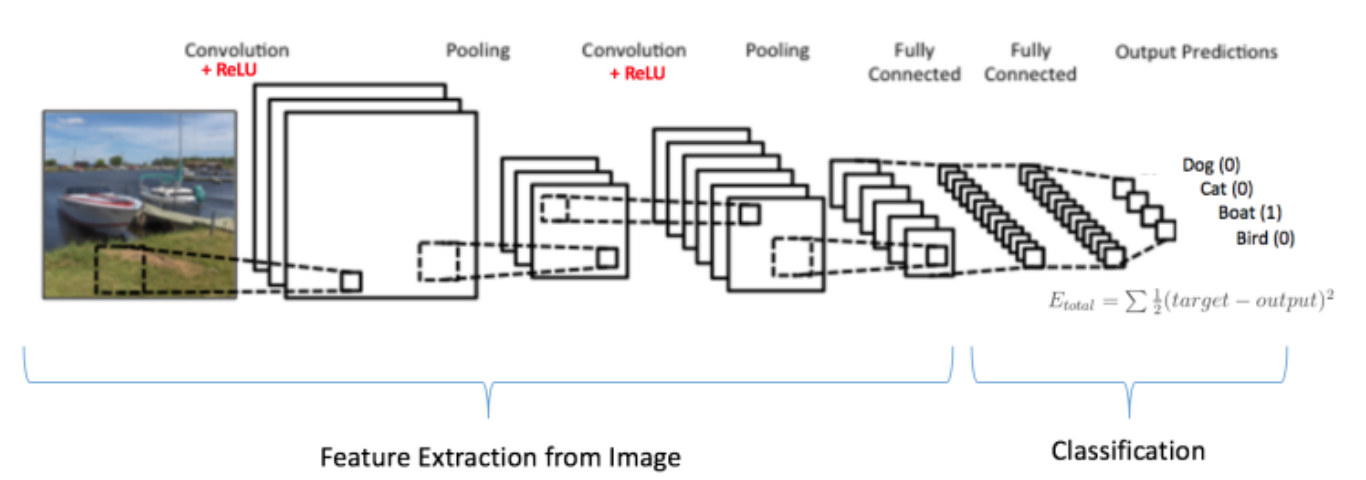

Convolution Calculation

-데이터가 너무 크니까 필터로 필요한 부분만 focusing

-x(=input data)*w(=filter=kernel)=feature map

pooling layer

• Feature map의 크기를 줄임 (down sampling, subsampling)

• MAX, MIN, AVERAGE, SUM….

• 노이즈 감소, 속도 증가, 영상의 분별력 좋아짐

• Pooling size: pooling 연산을 할 영역의 크기 (가로×세로)

• Stride: 한번에 얼마 만큼 이동할지 결정 (주로 pooling size와 같게 설정)

Fully Connected Layer

머신러닝 vs 딥러닝

-feature extration을 사람이 하냐 딥러닝이 하냐에 따라 나뉨

메인 딥러닝(뉴럴넷) 알고리즘들

• CNN (Convolution Neural Network) 계통

- 이미지 데이터의 분석

- 이미지 분류, labeling, object detection 등의 베이스로 활용

• RNN(Recurrent Neural Network) 계통

- 시계열 데이터(시간에 따른 값의 변화)의 처리 및 분석

- LSTM 알고리즘을 주로 활용

• Unsupervised NN 계통

- 데이터의 전처리(주요 성분 추출, 군집화, denoising 등)를 위해 활용

- Autoencoder (Feature Extraction)

- Self Oraganizing Map (클러스터링)

• 새로운 데이터를 추론 및 생성 (Generative Adversarial Network : GAN)

• 강화학습 기술과 병행 활용 (DQN : Deep Q-Network)

• 공통점 : 분석에 활용되는 X들의 조합을 자체적으로 수행하여, 자연의

패턴을 학습한다는 것!

• 서로 결합하여 활용되는 경우도 많음 (ex. 시간에 따른 이미지 변화)

'Major > Data Analysis' 카테고리의 다른 글

| Distance & Unsupervised Learning Algorithm (0) | 2024.06.17 |

|---|---|

| Modeling (Artificial Neural Network) & Deep Learning-1 (0) | 2024.06.17 |

| SVM(support vector machine) (0) | 2024.06.17 |

| Decision Tree(의사결정나무) (0) | 2024.06.17 |

| KNN (0) | 2024.06.17 |